Nachdem das europäische Parlament Mitte Juni seine Position zum KI-Gesetz beschlossen hat, laufen die Trilog-Verhandlungen mit Rat und Kommission nun auf Hochtouren. Im Kern geht es bei der Debatte um die Regulierung von Künstlicher Intelligenz (KI) in Europa darum, die Chancen der Technologie zu nutzen und ihre Risiken zu begrenzen, zwischen Innovation und Risikoprävention sensibel abzuwägen. Je nachdem, wie man diese Abwägung trifft, folgen gegensätzliche Handlungsempfehlungen: Kritiker fordern schärfere Regeln für Hochrisiko-Systeme und Transparenzauflagen, während europäische Unternehmen gravierende Wettbewerbsnachteile befürchten.

Im globalen Vergleich wird deutlich, dass die aktuellen Regulierungspläne der Europäischen Union (EU) die Sichtweise der Kritiker klar priorisieren. Abgesehen von den USA, die im Bereich der KI eine Führungsrolle einnehmen und deswegen neben sicherheitspolitischen Gründen schon allein aus industriepolitischen Interessen heraus eine laissez-faire Attitüde einnehmen, hat sich das Vereinigte Königreich zuletzt als innovationsfreundlichere Alternative zur EU positioniert – und damit das erste europäische Büro von Open AI, dem Entwickler des Sprachbots ChatGPT, angelockt. Selbst das traditionell risikoaverse Japan sieht KI-Regeln vor, die sich gegenüber dem europäischen Vorschlag als lockerer und flexibler ausnehmen.

Um zu vermeiden, dass das europäische KI-Ökosystem im Keim erstickt wird, muss das KI-Gesetz im Trilog dringend angepasst werden. Doch wie könnte eine praktikable Regulierung von KI in Europa aussehen, die das Missbrauchs- und Risikopotenzial ernst nimmt, aber gleichzeitig Raum für Entwicklung, Innovation und Wettbewerbsfähigkeit lässt? Um diese Frage konzeptionell zu beantworten, muss man sich die grundlegenden Eigenschaften der neuen Technologie vergegenwärtigen, denn von ihnen hängt die Wahl eines adäquaten Regulierungsansatzes ab.

Die falsche Angst vor dem Kontrollverlust

KI hat im Vergleich zu anderen Technologien zwei spezifische Eigenschaften: Sie entwickelt sich exponentiell, wie die immensen Leistungsschübe immer größer werdender Sprachmodelle verdeutlichen. Zudem entwickelt sie sich aufgrund eines Lernens höherer Ordnung teilweise autonom, sprich: KI entwickelt tatsächlich eine Form der Intelligenz, die es ihr ermöglicht, sich selbst fortzuentwickeln. Beschleunigung und Eigengesetzlichkeit der technologischen Entwicklung prägen die Sorge vor Kontrollverlust. Die Angst vor KI resultiert aus der Befürchtung, dass sich KI ab einem bestimmten Punkt der Entwicklung irreversibel entkoppelt und dann der Kontrolle des Menschen für immer entzieht. Die Aufgabe der Regulierung wäre es aus dieser Sicht, bereits heute diesen Kipppunkt in die Singularität durch höchste Risikoaversion zu verhindern. Doch im Gegensatz zu Dystopien, die im Unendlichen zu einem unvermeidlichen Untergang der Menschheit konvergieren, wird es in der Zukunft nicht ein alles dominierendes KI-Modell geben, dessen Fehler schlagartig eine ganze Gesellschaft auslöschen können.

Diesen Prämissen folgend ist die EU in ihrer übermäßig kritischen Positionierung einer naheliegenden, aber wenig zielführenden Analogie zum Opfer gefallen. Die dystopischen Narrativen einiger kalifornischer KI-Eliten aufgreifend, wird die Potenz von KI in Europa gerne mit der Gefahr eines nuklearen Unfalls, einer Pandemie oder gar Chemiewaffen verglichen. Das suggeriert, dass die existenzielle Gefahr der KI durch zahlreiche präventive Maßnahmen von Anfang an zu adressieren ist. Doch auch wenn sich KI exponentiell und teils autonom entwickelt, trügt diese Analogie. Die Risiken der KI werden wir erst mit ihrer Entwicklung verstehen, und nur in der Anwendung werden wir lernen können, diese Risiken zu beherrschen. Entwicklung und Anwendung von KI lassen sich daher nicht trennen. Genau das aber propagiert die Kommission, indem die Regulierung der Anwendung den Pfad der Entwicklung prädeterminieren soll. Der Technologie-Alarmismus aber schürt lediglich die Angst vor KI und lenkt davon ab, wie sie robust und wohlfahrtsteigernd entwickelt werden kann. Stattdessen vermuten selbst heutige Big Tech-Unternehmen, dass trotz einer gemeinsamen Technologiebasis sukzessive ein dezentrales, oft auf Open-Source basierendes Ökosystem an Modellen entstehen wird – Modelle, die wiederum auf verschiedene Anwendungsgebiete hin feinjustiert und sogar personalisiert werden können.

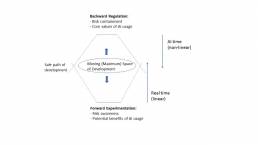

Abbildung: Ein risikobasierter und potenzialorientierter Regulierungsansatz für KI

Warum das Automobil eine bessere KI-Analogie als die Kernkraft ist

So wie KI ist das Automobil ein so mächtiges Werkzeug, weil sie es dem Menschen ermöglicht, mit weniger Aufwand mehr zu erreichen: weniger Zeit, um ein fernes Ziel zu erreichen; weniger Kosten und Aufwand, um Neues zu entdecken. Aber eben diese Fähigkeiten machen beide Technologien in den falschen Händen auch zu einer gefährlichen Waffe. Entscheidend ist, dass die Gefahr nicht von der Technologie an sich ausgeht – die vielmehr anwendungsneutral ist – sondern von der Handhabung durch den jeweiligen Nutzer. Das Auto kann zum Supermarkt gefahren werden – oder in eine Menschenmenge hinein. Es ist realitätsfern zu glauben, dass man alle KI-Probleme mit einem Schlag lösen könnte, so wie auch das Sicherheitsproblem bei Autos nicht von heute auf morgen gelöst wurde. Wie der leitende KI-Experte von Meta, Yann LeCun, vor Kurzem betonte, ist die Entwicklung von robuster KI immer ein Prozess der kontinuierlichen und iterativen Verbesserung.

Schaut man auf den jüngsten KI-Siegeszug aus automobilgeschichtlicher Sicht, und nicht durch die Brille einer existentiellen nuklearen Gefahr, leiten sich andere regulatorische Schwerpunkte ab. Im Gegensatz zur Kernkraft ist das Automobil einfacher und breiter zugänglich, birgt verhältnismäßig weniger Risiken und bietet mehr Möglichkeiten zur Interaktion und Steuerung. So wie Autos in unserem täglichen Leben eingesetzt werden, wird KI zunehmend in unseren Alltag integriert. Doch im Gegensatz zu den potenziell katastrophalen Unfällen von Atomkraftwerken sind die Risiken im Zusammenhang mit der KI, so wie beim Automobil, in der Regel kleiner und können durch Forschung und Standards leichter und schneller vermieden werden. So wie man als Nutzer des Autos dieses beschleunigen, bremsen und die Richtung ändern kann, können wir KI-Systeme entwerfen, trainieren und justieren, um bestimmte Bedürfnisse zu erfüllen. Das lässt Raum, um unter Rahmenbedingungen wettbewerblich zu experimentieren und inkrementell zu verbessern. Grundlegende Bedingung dafür ist, dass dem Menschen Wahlmöglichkeiten bleiben, denn dies schließt die aufgeklärte Entscheidung für eine sichere, und humane, KI ein. Mündigkeit und Wettbewerb sind daher wesentliche Voraussetzungen dafür, dass Regulierung überhaupt greifen kann.

Die Analogie mit dem Auto suggeriert, dass eine gute Regulierung von KI vor allem drei Dinge benötigt: grundlegende Sicherheitsstandards, bevor ein Modell zum Einsatz kommt; einheitliche Verkehrsregeln sowie ausgebildete Fahrer, die die neue Technologie für Alltagsaufgaben oder die Erkundung ganz neuer Landschaften einsetzen können – ohne freilich ihre Mitfahrer dabei in übermäßige Gefahr zu bringen. So wie die Straßenverkehrsordnung über einen langen Zeitraum hinweg ein dynamisches, sich weiterentwickelndes System kontrollieren konnte, ohne dieses zu sehr einzuschränken, könnte eine solche KI-Regulatorik innovationsgetrieben und in gewissem Maße technologieoffen bleiben. Diese sequentielle Regulierung berücksichtigt den Entwicklungspfad des KI-Lebenszyklus besser als ein statisches Modell.

Welche konkreten Verkehrsregeln braucht es?

Um am Verkehr teilnehmen zu dürfen, muss das Auto erst zugelassen werden und dafür bestimmte Sicherheitsanforderungen erfüllen. Auch bei den vielfach beschriebenen Sicherheitslücken moderner KI – die von Verzerrungen in den Trainingsdaten bis hin zu mangelhafter Transparenz über die Funktionsweise reichen – bietet es sich an, einen gewissen Grundschutz vorzuschreiben. Viele der im KI-Gesetz der EU angeführten Verpflichtungen gehen dafür in die richtige Richtung, doch die Lastenverteilung ist entscheidend. Strikte Auflage für Hochrisiko-Systeme sollten für Forschungszwecke und KMUs, deren Modelle den Massenmarkt absehbar nicht betreten werden, keine Rolle spielen. Auch die vom EU-Parlament vorgesehene Grundrechte-Folgenabschätzung sollte nur auf die Entwickler anwendbar sein. Die Sicherheit des Autos gewährleistet der Hersteller, nicht der Fahrer. Folglich sollten die Trilog-Verhandler die meiste Verantwortung den Entwicklern von KI-Systemen mit allgemeinem Verwendungszweck zuweisen, da diese über die notwendigen Ressourcen und Kenntnisse verfügen, um die Vorschriften einzuhalten. Aspekte, die für die grundlegende Sicherheit nicht unmittelbar relevant sind, wie etwa Umweltaspekte von KI-Testumgebungen, sollten hingegen an dieser Stelle ausgeblendet werden.

Nach erfolgter Zulassung auf dem europäischen Markt sollten sich die Modelle – der Analogie weiter folgend – restriktionsfrei und einfach bewegen können. Eine national divergierende Umsetzung des KI-Gesetzes ist unbedingt zu vermeiden, denn es braucht einheitliche Verkehrsregeln, sprich allgemein verständliche und eindeutig operationalisierbare Definitionen und Standards. Dafür müssen Experten aus der Industrie einbezogen werden, so wie das auch bei Automobilen und dem TÜV der Fall ist. Während einige EU-Datenschutzbehörden bereits Befugnisse zur Überwachung von Algorithmen übernommen haben, legt die Analogie zum Automobil nahe, dass es für die Durchsetzung der KI-Regeln ein europäisches KI-Office braucht, um Fragmentierung zu vermeiden und die Verbindungen zur Datenschutzgrundverordnung, dem Data Act und dem Digital Markets Act zu koordinieren.

Schließlich sind die Fahrer selbst gefragt – ein Aspekt, der in der Debatte bislang untergeht. So wie es notwendig ist, einen Führerscheinkurs zu absolvieren, um Auto fahren zu dürfen, so braucht es im KI-Zeitalter eine gesellschaftsweite digitale Mündigkeit und „KI-Literacy“, um mit den Potentialen und Risiken der neuen Technologie gebührend umzugehen. Das reduziert die Gefahr, dass sich Deep Fakes leichter verbreiten oder die KI in falschen Kontexten, die eher einen menschlichen Umgang erfordern oder besonders fehlersensibel sind, eingesetzt wird. In Finnland gibt es mit dem kostenfreien Onlinekurs „The Elements of AI“, der schon von mehr als 140.000 Menschen absolviert wurde, ein gelungenes Beispiel für eine solche Aufklärungsoffensive. Als erster Schritt sollte ein KI-Führerschein für den behördlichen Einsatz von KI zügig verpflichtend gemacht werden, da die Entscheidungen dieser Beamten besonders weitreichend und gesellschaftsrelevant sind.

Der Weg nach vorne

Bis zur breiten Einführung von KI in der europäischen Wirtschafts- und Gesellschaftsordnung ist es noch ein weiter Weg – um ihn zu begehen, braucht es nicht nur dynamische Verkehrsregeln, sondern vor allem auch Verkehrsteilnehmer mit digitaler Mündigkeit und dem Interesse, neue Wege zu erkunden. Die technologischen Eigenschaften der KI prädeterminieren den Regulierungsansatz, nicht umgekehrt. Wer KI nicht entwickelt, wird ihre Anwendung nicht verstehen. Wir müssen deshalb an und mit ihr lernen. Sequentiell den Raum der Entwicklung vorwärts anzupassen und gleichzeitig vom Ende her grundlegende Werte zu schützen, ist die große Herausforderung. Angesichts der hohen Geschwindigkeit und dem enormen Potenzial der KI gibt es keine Alternative dazu, die Technologie in einem stückweise abgesicherten Modus zu entwickeln. Europa reklamiert zurecht, den ersten ganzheitlichen Ansatz zur Regulierung der KI auf den Weg gebracht zu haben. Es wäre bittere Ironie, wenn Europa damit einen führenden Einfluss auf die Entwicklung und Anwendung von KI aufgegeben hätte. Wer seine Werte im KI-Zeitalter verteidigen möchte, muss den Anspruch erheben, sie führend zu entwickeln. Diesen Anspruch gibt Europa gerade auf.

Weitere Artikel zum Thema KI in Europa:

Henning Vöpel ist Vorstand des Centrums für Europäische Politik (cep). Zwischen September 2014 und Oktober 2021 war er Direktor und Geschäftsführer des Hamburgischen WeltWirtschaftsInstituts (HWWI). Zuvor war er Senior Economist am HWWI und zeichnete verantwortlich für die Forschungsbereiche Konjunktur und Weltwirtschaft. Seine Forschungs- und Themenschwerpunkte sind Konjunkturanalyse, Geld- und Währungspolitik, Finanzmärkte und Digitalökonomie.

Anselm Küsters ist Fachbereichsleiter Digitalisierung/Neue Technologien am Centrum für Europäische Politik (cep), Berlin. Als Postdoktorand an der Humboldt-Universität zu Berlin und assoziierter Wissenschaftler am Max-Planck-Institut für Rechtsgeschichte und Rechtstheorie in Frankfurt am Main forscht er im Bereich der Digital Humanities. Küsters erwarb einen Master in Wirtschaftsgeschichte an der University of Oxford (M. Phil.) und promovierte an der Johann Wolfgang Goethe University in Frankfurt am Main.

Copyright Header Picture: shutterstock/ParabolStudio; Skizze: eigene Darstellung

Könnte Sie auch interessieren

23. Juli 2024

The EU’s new industrial agenda: A deal for the few?

In her candidature speech, the newly re-elected EU Commission President von der…

1. Juli 2024

European Parliamentary Elections: A Debacle for Pro-EU Parties or Their Last Chance?

Between 6 and 9 June, 400 million Europeans voted in the European Parliamentary…

21. Juni 2024

From Bytes to Bedside: Improving Real-World Applications with Synthetic Data

With the latest advances in synthetic data generation, the economic potential…